精确的信道状态信息(CSI)对于B5G/6G MIMO无线通信系统性能保障至关重要。然而,在高速移动场景下,信道相干时间大大缩短,传统信道估计方式难以及时准确地获取CSI,导致“信道老化”现象。例如,当用户速度超过60km/h时,可达传输速率相对于静止状态会下降30%以上。信道预测是实现CSI高效获取的一项核心技术,其根据历史时刻CSI序列预测未来CSI,从而大大减少信道估计与反馈开销。但现有的基于参数化模型和深度学习的信道预测方法存在预测精度低和泛化性差等问题,难以应用到实际复杂信道环境。

近期,GPT-4和LLaMA等大语言模型(LLM)在自然语言处理等领域取得了巨大的成功,并逐步应用于金融、医疗和教育等特定领域。通过在大规模数据集上进行预训练,大语言模型获得了强大的通用建模能力和泛化能力。然而,当前大语言模型在通信任务上的应用局限于语言形式的协议理解等任务,限制了其在物理层的应用范围。那么,大语言模型能否突破语言局限,赋能非语言形式的无线通信物理层任务?为此,程翔教授团队以信道预测任务为突破点,尝试利用预训练大语言模型提升信道预测的预测精度和泛化能力。然而,利用预训练大语言模型直接处理非语言形式的CSI数据存在以下挑战:

1)不同于文本数据,CSI为高维结构化数据,具有复杂的“空-时-频”三维关系;

2)自然语言域和信道域的知识存在域差异(domain gap),进一步增大了知识迁移的难度。

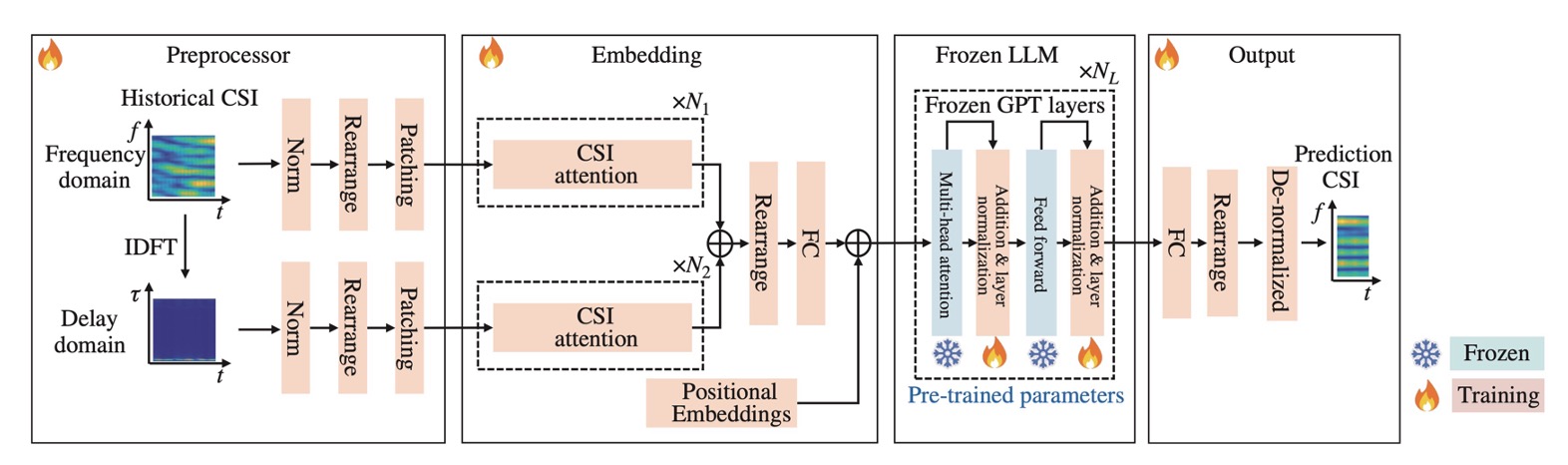

克服以上挑战,程翔教授团队提出了一种基于预训练大语言模型的MIMO-OFDM信道预测方案,可应用于TDD和FDD通信系统。团队构建了一个基于预训练GPT-2的信道预测网络,包含预处理模块、嵌入模块、预训练LLM模块和输出模块,如图1所示。在训练过程中,预训练LLM的多头注意力层和前馈层保持冻结,以保留预训练LLM中的通用知识。为解决空域高维问题,将天线维并行化处理,在降低网络开销的同时提升了任务的可扩展性。为充分捕获频域特征,充分考虑信道结构化特征,引入时延域以直接刻画多径时延特征。为有效提取时域特征,采用分块处理,捕获局部时域变化特征,并降低计算复杂度。此外,为了克服域差异,设计了嵌入模块将预处理后的特征进一步处理,以对齐预训练LLM的特征空间。

图1:所提出的基于预训练大语言模型的信道预测网络框架

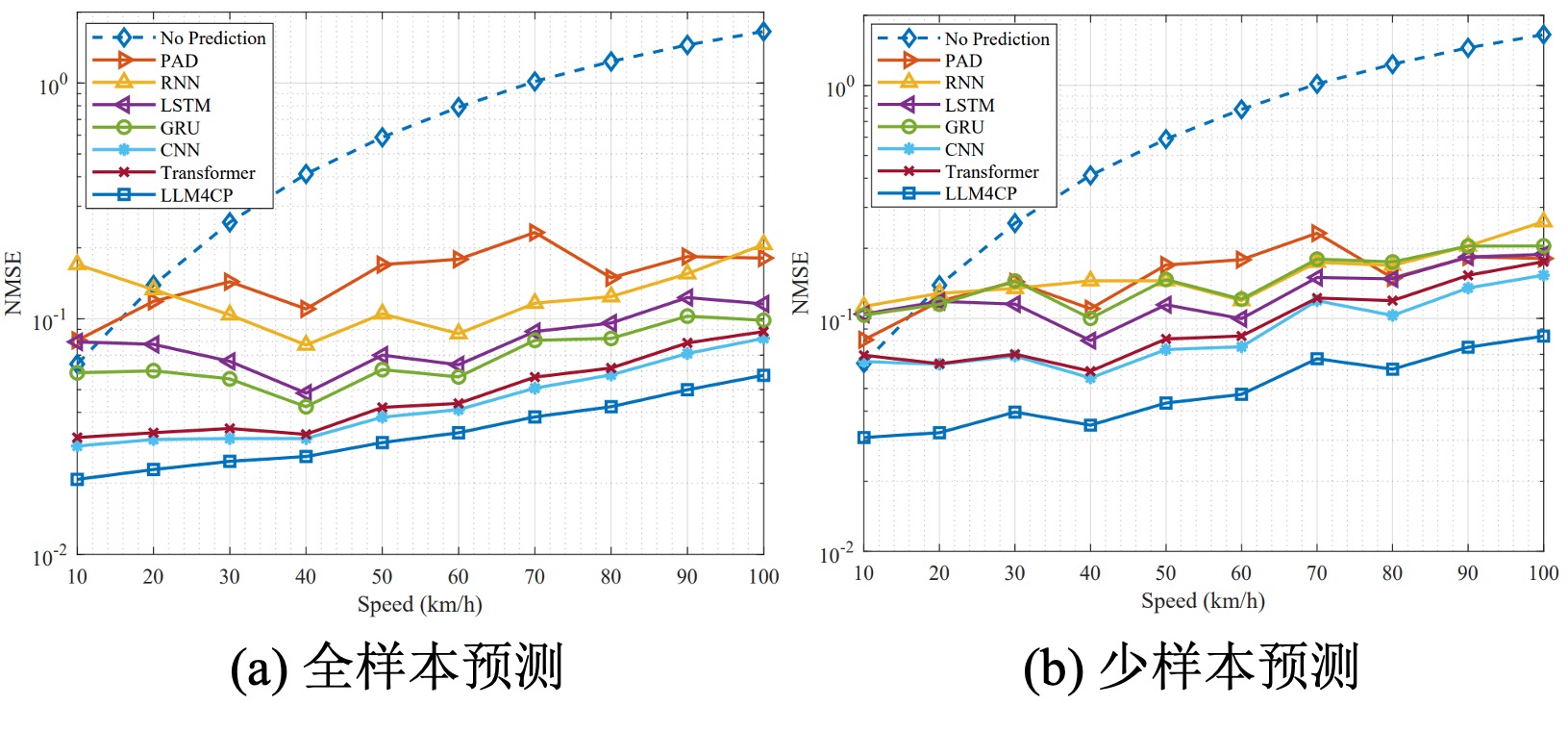

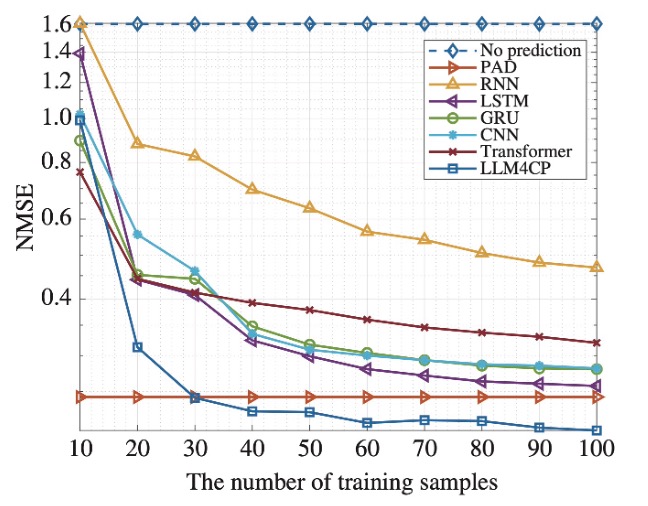

团队使用QuaDRiGa仿真器生成了符合3GPP标准的时变信道数据集用于性能验证。仿真结果显示,该方案的信道预测精度、可达速率和误码率均优于现有基于深度学习小模型和基于参数化模型的信道预测方案。在TDD场景下,全样本预测和少样本预测的NMSE(归一化均方根误差)相比次优方案分别降低1.35dB和2.49dB。在FDD场景下,全样本预测和少样本预测的NMSE相比次优方案分别降低1.30dB和0.30dB。在频点泛化性测试中,在2.4GHz频点训练完成的模型经过少样本训练泛化到4.9GHz频点,仅需30个样本就达到了参数化模型的预测性能,展现了优秀的泛化能力。此外,所提方案的训练和推理时间与基于深度学习小模型的信道预测方案相当,有望部署于实际场景。

图2:所提方案在TDD场景下的全样本预测和少样本预测(使用10%训练集)性能

图3:在2.4GHz频点训练完成的模型经过少样本训练泛化到4.9GHz

该工作的主要亮点如下:

(1)首次将预训练大语言模型应用于信道预测任务,证明了预训练大语言模型可以突破语言形式赋能无线通信物理层设计。

(2)设计了信道特征增强的神经网络,对齐信道空间与大模型特征空间,实现预训练大模型通用知识在信道预测任务上的良好迁移。

(3)仿真结果显示,所提出方案在TDD和FDD信道预测任务上取得了SOTA的全样本和少样本预测性能,频点泛化性能大幅领先于现有方案,同时具有和深度学习小模型相当的训练和推理时间开销。

文章信息:该研究成果以“LLM4CP: Adapting Large Language Models for Channel Prediction”为题受邀发表于期刊Journal of Communications and Information Networks上。北京大学为该研究工作的第一完成单位,合作单位包括香港科技大学(广州)和香港科技大学。程翔教授为该论文的通讯作者,北京大学博士生刘伯珣为第一作者。这项工作得到了国家自然科学基金委杰出青年科学基金、国家重点研发计划、新基石科学基金会科学探索奖等的支持。

论文地址:https://ieeexplore.ieee.org/document/10582829

代码和数据开源地址:https://github.com/liuboxun/LLM4CP